ブログ

生成AIのハルシネーションとは?発生原因と業務での具体的対策を徹底解説

この記事でわかること

- 生成AIのハルシネーションの定義と、発生しやすい場面

- ハルシネーションが業務にもたらすリスク

- 生成AIのハルシネーションがなぜ起こるのか

- 実務での基本対策方針

- 技術的アプローチの活用法

- 業界別の対策事例

ChatGPTの基本と使いこなすコツをまとめた資料を提供中!

Chat GPT以外の生成AIを活用する際の参考としてもご活用ください!

生成AIは業務の短縮や情報検索を効率化するツールとして注目されていますが、一方でハルシネーションという実際には存在しない制度や人物を紹介したり、信頼性の低い内容を正確な情報のように伝えてしまう現象が課題となっています。

こうした問題に対応するには生成AIの仕組みとハルシネーションの原因を理解した上で、実務に即した対策を講じることが不可欠です。

本記事ではハルシネーションが発生する主な原因や業務への影響を明らかにした上で、プロンプト設計やファクトチェック、技術的手法など具体的な対策を分かりやすく紹介します。

生成AIを効果的に業務へ取り入れるための方法を知りたい方は、ぜひ最後までご覧ください。

なお生成AIについて理解を深めたい方は、以下の参考記事もあわせてご確認ください。

目次

生成AIハルシネーションとは?

ハルシネーションとは、AIが本来存在しない情報や事実と異なる内容をあたかも正しいかのように出力してしまう現象のことです。

プロンプトの曖昧さ、未学習のテーマへの対応、似た情報の混同など、複数の要因が重なって発生することが知られています。

特に業務でAIを活用する場合には、誤情報が起こる原因をあらかじめ把握しておくことが重要です。

この章ではハルシネーションがよく起こる場面を紹介していきます。

生成AI利用時にハルシネーションが発生しやすい場面を紹介

AIによるハルシネーションは特定の条件が揃ったときに発生しやすくなります。

このような誤出力は情報の信頼性を損ない、業務に悪影響を及ぼす可能性があるため事前にハルシネーションが起こりやすいパターンを理解しておくことが重要です。

曖昧な質問や不完全な指示を与えたとき

生成AIに対して曖昧な質問や情報が不足したプロンプトを与えると、モデルは自動的に不足部分を補おうとします。

この補完は必ずしも事実に基づいているわけではなく、あくまで文脈上もっともらしい語句を予測して並べているに過ぎません。

その結果、見た目には自然でも実際には存在しない情報が出力されるという現象が発生します。

例えば「最近話題になっている法律について教えてください」といった指示を与えると、特定の法律名や内容をAIが推測して創作してしまうケースがあります。

曖昧な指示はAIの創作を誘発しやすいため、常に具体性のある問いを意識することが重要です。

学習データに存在しない情報を求めたとき

生成AIは学習済みのデータをもとに出力を行う仕組みであるため、その学習範囲に含まれていない情報について問われると、存在しない内容を補って回答しようとする傾向があります。

特に公開時期が新しい出来事やニッチな専門分野に関する情報は、学習データに含まれていない場合が多く、誤情報が生まれやすくなります。

例えば直近の法改正や地域限定の専門用語などについて質問した場合、AIは不正確な情報を事実のように提示する可能性があります。

似た情報が多く混同しやすい内容を扱ったとき

人名、企業名、製品名などが似ている場合、AIはそれらを混同してしまうことがあります。

類似したキーワードが多く登場する文脈では複数の情報を誤って合成し、実在しない架空の人物や企業として出力されるケースがあります。

例えば社名に共通する語句を持つ企業が複数存在する場合、それらが組み合わさって全く異なる存在としてAIが説明することがあります。

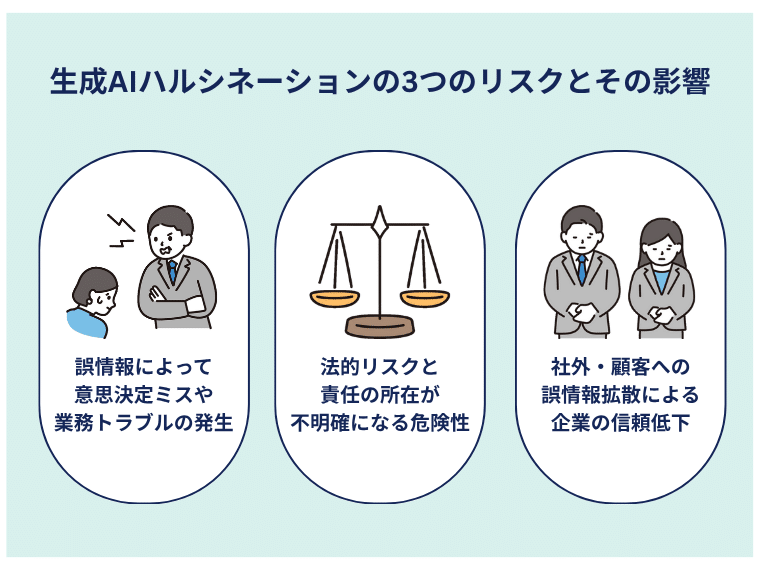

生成AIハルシネーションのリスクとその影響

ここまでハルシネーションが発生する原因について解説してきました。

しかし中には「ハルシネーションが起きても、特に問題はないのでは?」「そもそも、それほど重要な課題なのか?」と疑問に思う方もいるかもしれません。

この章ではハルシネーションによって生じるリスクや業務への影響について詳しく解説します。

誤情報によって意思決定ミスや業務トラブルがおこる

生成AIが誤った情報を出力すると、それをもとに社内で誤った判断が下されるおそれがあります。

特に業務の進め方や意思決定に影響を及ぼすケースでは、誤情報が実務上の混乱を引き起こす原因となります。

例えば社内報告書や稟議資料にAIの回答をそのまま引用した場合、誤情報が混入していると部門間での判断を誤らせてしまいます。

また社内チャットや調査代行などAIを日常業務に取り入れている場合も確認を怠ると業務の混乱を招く恐れがあります。

法的リスクと責任の所在が不明確になる危険性がある

生成AIを契約書や通知文など法的文書に利用する際には、誤った内容による法的リスクと責任の所在が不明確になる危険性に注意が必要です。

例えばAIが出力した契約文に不備や誤解を招く表現があると相手方との認識にズレが生じ、契約内容の齟齬や法的トラブルに発展する可能性があります。

特に金額や契約期間、義務範囲といった重要項目に誤りがあると契約の有効性そのものが問われ、損害賠償請求に至ることもあります。

またAIが生成した内容を誰が確認・承認したかという記録がないと問題発生時に責任の所在が曖昧になり、組織の信頼性やガバナンス体制に悪影響を及ぼすおそれがあります。

社外・顧客への誤情報拡散により企業の信頼が下がる

営業資料やWebサイトチャットボットなどにAIの出力を利用した場合、内容に誤りがあると顧客や取引先に誤解を与える可能性があります。

一度誤情報が公開されると、訂正をしても信頼回復には時間がかかり企業価値を損なう恐れがあります。

特に提案書やプレゼン資料など外部との接点が多い場面では、誤情報の影響が大きくなるため慎重な確認が欠かせません。

なぜ生成AIハルシネーションは起こるのか

ここまでAIがハルシネーションを起こしやすい場面や、それに伴うリスクについて解説してきました。

ではなぜそもそもハルシネーションは発生するのでしょうか。

本章ではAIが事実と異なる内容を出力してしまう根本的な原因について整理し、どのような仕組みで誤情報が生まれるのかを明らかにしていきます。

AIの限界や特性を理解することで、ハルシネーションへの適切な対策にもつながります。

言語モデルの仕組みに限界があるから

現在主流の大規模言語モデルは人間のように意味を理解して出力しているわけではなく、膨大なテキストデータから文脈上もっとも自然と推測される単語列を確率的に選択して出力しています。

このような仕組みである以上、内容の正誤を判断する機能は備わっておらず情報の信憑性よりも文章としての自然さが優先される結果誤情報が生成される余地が常に存在しています。

学習データの偏りや不足があるから

生成AIは主にインターネット上の公開データや各種文書をもとに学習していますが、その中には誤情報古い情報偏見を含んだ記述も少なくありません。

例えば特定の地域や分野に関する情報が極端に少ない場合、その領域では不正確な内容を出力する可能性が高くなります。

また一部の視点に偏った情報ばかりが学習されていると、出力結果にもそのバイアスが反映されることになります。

曖昧なプロンプトが誤情報を引き起こしやすいから

プロンプトが抽象的だったり質問の意図が明確でなかったりすると、AIは不明な部分を自動的に補完しようとします。

補完の結果として最終的に存在しない情報をもっともらしく出力する事例が多く報告されています。

例えば「ある企業の最新の成功事例を教えてください」といった漠然とした問いを投げかけると、企業名業種成果内容などを創作してしまう可能性があります。

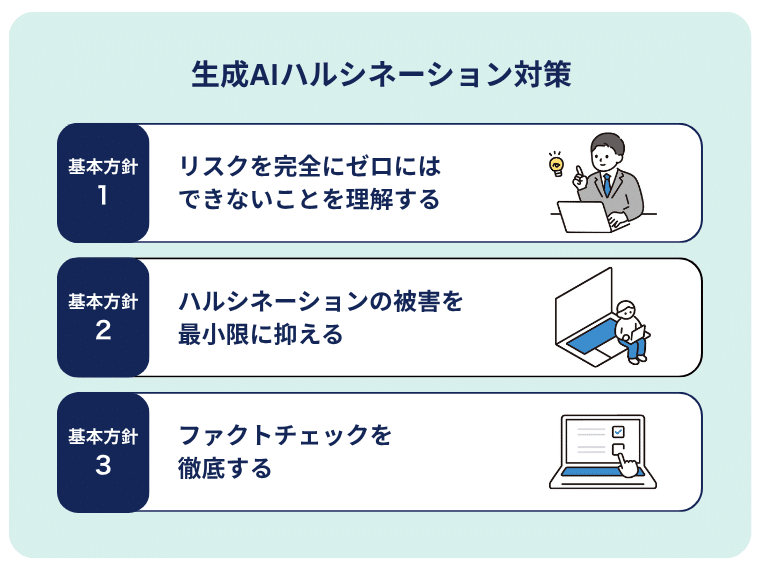

生成AIハルシネーション対策の基本方針

AIはあくまで確率に基づいて文章を構成する仕組みで動作しており、その特性上、出力の正確性が保証されるわけではありません。

つまり誤情報が含まれる可能性を前提とした上で、どのように使うかという視点が不可欠となります。

重要なのは誤りをゼロにすることを目指すのではなく、誤りが発生しても適切に検知・制御できる体制を整えることです。

本章ではそのための基本方針として、実務における運用ルール、確認プロセス、リスク管理の考え方を紹介します。

リスクを完全にゼロにはできないことを理解する

生成AIは便利なツールである一方で、仕組み上どうしても誤情報を出力してしまうリスクを抱えています。

正確性を保証できない理由はモデルの構造そのものに起因するものもあれば、学習データの性質や現実の業務環境とのギャップに起因するものもあります。

たとえ活用方法を工夫したとしても、すべてのリスクを排除することは現実的ではありません。

このような限界を理解した上で、誤情報が出力される前提で生成AIを使いこなしていく姿勢が重要です。

言語モデルは意味ではなく確率に基づいて出力している

生成AIは文章の意味を理解して回答しているわけではありません。モデルの内部では大量の学習データをもとに、次に続く単語が文脈上もっとも自然になるように確率で選ばれています。

つまり出力される文章が意味的に正しいかどうかではなく、見た目として自然であるかどうかを優先して構成されているのです。

この特性により、あたかも正確な内容であるかのように見える誤情報が混入することがあります。

学習データに誤りや偏りが含まれている可能性がある

AIが学習するデータには誤情報や古い情報、特定の立場に偏った記述が含まれている場合があります。

インターネット上の情報は信頼性にばらつきがあり、すべてが正確で中立的とは限りません。

またある分野について十分な情報が存在しない場合には補完的な創作が入り込む可能性が高くなります。

こうした性質から、出力された情報の背景にはどのようなデータが影響しているかを意識する必要があります。

全ての利用ケースや文脈をモデルが理解・対応できるわけではない

生成AIは人間のように文脈全体を読み取って柔軟に対応する力を持っているわけではありません。

たとえば質問者の業務背景、所属部門の目的、過去のやり取りなど、状況に応じた前提を読み取ることはできません。

明確に指示されていない情報は、たとえ人間であれば理解できる内容であってもAIにとっては解釈が難しくなります。

その結果、求められていない情報を出力したり文脈から外れた回答を返したりすることがあります。

ハルシネーションの被害を最小限に抑える

基本的な対策として挙げられるのは、AIが生成した内容をそのまま使用するのではなく、人の目による確認工程を必ず挟むことです。

特に顧客向けの資料や契約書など外部に影響を与える文書においては、情報の正確性が求められるため事前のチェックが不可欠です。

加えてAIを業務プロセスに組み込む際には、ファクトチェックや承認ステップを明確にルール化し、属人的な運用を避ける体制を整えることが重要です。

こうした管理を意識することで、ハルシネーションの影響を最小限にとどめることが可能になります。

ファクトチェックを徹底する

AIは出力の根拠となる情報を必ず示すわけではないため、その内容をそのまま信じて利用すると誤情報を拡散する恐れがあります。

特に出典の記載がない情報や断定的な語調で提示される内容については、必ず一次情報や信頼できる資料と照合することが求められます。

社内でチェックリストや確認フローをあらかじめ整備しておくことで、誰がAIを使っても一定の基準で検証を行える体制が構築できます。

生成AIの利便性を活かしつつ誤情報によるリスクを避けるためには、事実確認の習慣を日常的に業務に組み込むことが必要です。

技術的アプローチによる生成AIハルシネーション対応

本章では生成AIのハルシネーションを抑制するために活用されている代表的な技術的手法について紹介します。

どの方法も出力される内容の正確性や信頼性を高めるために設計されており、業務やサービスへの応用が進められています。

ここからは特に注目されている三つの技術であるRAG、Chain-of-Thought、ファインチューニングについて解説します。

RAG(Retrieval-Augmented Generation)

RAGは外部の情報ソースを参照しながら文章を生成する手法です。

通常の生成AIはあらかじめ学習されたデータだけを使って回答を出力しますが、RAGでは質問に応じてリアルタイムで社内データベースや信頼できるドキュメントから情報を検索し、それを参照しながら回答が構成されます。

この仕組みにより、知識の鮮度と正確性を保ったまま生成を行うことが可能になります。

RAGは特定の業界や企業固有の情報に基づいた回答が求められる場合に特に有効です。

Chain-of-Thought

Chain-of-Thoughtは回答に至る思考の流れを段階的に言語化させるアプローチです。

従来の生成モデルでは最終的な答えのみが表示されることが一般的でしたが、この手法を用いることで、結論までの推論過程を明示的に出力させることが可能となります。

条件が複雑な計算や推論が求められる場面においては、途中経過をあらかじめ提示することで、飛躍した論理展開や誤った結論に至るリスクを抑制できます。

加えて、推論の各ステップが記述されていることで人が内容を後から確認・検証しやすいというメリットもあります。

ファインチューニング

ファインチューニングは既存の生成AIに対して特定の業務や目的に合わせた追加学習を行う方法です。

汎用的に訓練されたモデルに対して自社独自の文書やルール、ドメイン知識などを反映させることで、出力の内容がより業務に即したものになります。

ハルシネーションを抑えるという点では不要な情報の補完を減らし、業務に必要な表現や判断基準に寄せた出力を得られることが強みとなります。

運用にはコストや技術的な工夫が必要ですが、高い再現性と信頼性が求められる場面では有効な選択肢となります。

各業界における生成AIのハルシネーションの対策例

本章では、生成AIの出力ミスが重大な影響を及ぼす可能性がある領域におけるハルシネーション対策の取り組みを紹介します。

誤情報によって判断ミスや法的トラブルが生じるおそれがある場面では、AIの導入や活用に対して特に慎重な姿勢が求められます。

ここでは法務、医療、金融といった分野における代表的な対策事例を取り上げ、どのように実務とバランスを取りながらリスクを最小限に抑えているのかを見ていきます。

法務領域:根拠の明示と人によるチェックの徹底

契約書のレビューや法令に関する調査支援など、生成AIは法務の現場でも利用され始めています。

しかし誤った条文の引用や存在しない判例の生成といったリスクがあるため、そのまま業務に活用することはできません。

導入事例では出力に対して根拠の明示を必須とし、人によるファクトチェックを経て初めて業務に反映するという体制が構築されています。

また契約書作成支援ツールでは、法的に有効なひな型のみをAIに学習させ、不要な創作を抑える工夫がされています。

こうした二重三重の対策により、ハルシネーションの影響を最小限にとどめる取り組みが進んでいます。

医療領域:専門家の監修と使用範囲の制限

医療分野では患者の健康に関わる判断が必要とされるため、生成AIの活用には慎重な検討が必要です。

診断補助や医療文書の下書きなど限定的な用途に絞ることで、誤情報による誤診や不適切な処方のリスクを回避しています。

実際の運用では出力された内容がすべて医師の確認を通ることを前提とし、AIが単独で診断結果を提示するようなケースは想定されていません。

また医療データはプライバシー性も高いため、生成AIには匿名化された情報や構造化データのみを入力するなど、取り扱いにも工夫が凝らされています。

金融領域:説明責任と監査ログ保存

金融機関においては、生成AIを活用した情報提供や文書作成の場面で透明性と説明責任がこれまで以上に重視されるようになっています。

顧客との信頼関係を維持し、正確な情報発信を行うためにも、この2つの要素は欠かせません。

誤情報によって顧客に誤解を与えるリスクを避けるため、生成AIが出力した内容については必ず人が確認を行う体制が整えられています。

特に金融という性質上、扱う情報の正確性や信頼性が極めて重要となるため、AIを業務に取り入れる際には人によるチェックを前提とした運用が基本とされています。

まとめ

生成AIは便利なツールである一方、出力には誤情報が含まれる可能性が常にあり、ハルシネーションは避けがたい課題です。

生成AIの特性を理解したうえでプロンプト設計、ファクトチェック、RAGなどの技術的手法を組み合わせれば、リスクを抑えることが可能です。

また人による確認や責任の明確化を含む運用体制を整えることも欠かせません。

生成AIを安全に業務へ活用するには、出力を無条件に信頼しない前提で検証プロセスを取り入れることが重要です。

そのうえで自社の業務に適した使い方を見極め、セキュリティや情報管理も含めた全体的な活用方針を構築していくことが求められます。

一方でこうした理想に対して「生成AIとkintoneを活用して業務を効率化したいが、技術面に不安がある」「セキュリティの懸念から生成AIの導入に踏み切れない」等といった課題を感じている方も多いのではないでしょうか。

Smart at AIはkintoneと連携しながらChatGPTなどの生成AIを簡単に、そして安全に活用できるサービスです。

社内の業務改善とセキュリティ対策を両立しながら、生成AIを現場で活かすための仕組みを提供しています。

ハルシネーションを防止するRAG機能も提供しています。

導入に関するご相談や、具体的な活用方法については、下記サービスページをご覧ください。

\M-SOLUTIONS(Smart at AI)へのお問い合わせ/

資料ダウンロードはこちら お問い合わせはこちらChatGPTの基本と使いこなすコツをまとめた資料を提供中!

Chat GPT以外の生成AIを活用する際の参考としてもご活用ください!

![Smart at M-SOLUTIONS[stg]](https://smartat.jp/wp-content/uploads/2023/02/logo.png)