ブログ

生成AIのセキュリティとは?リスクの種類と企業が取るべき対策ステップ

この記事でわかること

- 生成AI×セキュリティの論点

- リスク全体像

- 影響範囲と事例

- 三層の対策

- 導入ステップ

- 最新動向と実務示唆

kintoneをもっと便利にするプラグイン・連携サービスを提供中

全サービスが乗っているカタログを今すぐ無料ダウンロード!

生成AIの導入が急速に進む一方で、「情報漏洩は大丈夫か?」「誤情報のリスクはどう防ぐ?」「法的リスクに対応できるのか?」といったセキュリティ面への不安を抱える企業や担当者が増えています。

従来のITセキュリティとは異なり、生成AI特有の脅威も登場しており、単なる「ITリテラシー」では対応しきれない現実があります。

本記事では生成AI活用におけるセキュリティリスクの全体像と、それに対する具体的な対策を体系的に解説します。

リスクの種類や事例、実務で取り入れるべきセキュリティ対策、導入ステップ、最新の成功/失敗事例まで幅広く紹介し、皆さまが「自社にとって今すべきセキュリティ対策は何か?」を明確にできるようご説明いたします。

生成AIを安心・安全に業務へ活用するための実践的な知識を身につけたい方は、ぜひ最後までご覧ください。

kintoneで利用できる生成AIソリューションである「Smart at AI」について詳しく知りたい方はこちらをご確認ください。

目次

生成AIで重要なセキュリティとは

生成AIは業務効率化や創造性の向上といったメリットから、多くの企業が導入を進めています。

しかしその一方で、「セキュリティ」への配慮が不十分なまま活用が広がっていることが課題となっています。

従来のITシステムと異なり、生成AIには特有のリスクが存在しそれを正しく理解し対策を講じなければ、情報漏洩や法令違反、誤情報拡散といった深刻なトラブルを引き起こす恐れがあります。

このセクションではなぜ今「生成AIのセキュリティ」が注目されているのか、そして企業や組織が何を押さえるべきかを順を追って解説します。

生成AIの活用が進む中でセキュリティが注目される理由

生成AIの活用は業種・業界を問わず急速に進んでおり、社内業務の効率化や顧客対応の自動化など、さまざまな領域で成果を上げつつあります。

しかし、AIによって生み出されるコンテンツや判断結果には、これまでのシステムとは異なるリスクが潜んでいます。

特に、①入力内容が外部に漏洩するリスク②AIが誤情報を生成する可能性(ハルシネーション)③法的リスクや社会的影響の拡大の3点がセキュリティ面での大きな懸念となっています。

こうした背景から単なるIT部門の問題としてではなく、経営層や事業責任者を巻き込んだ全社的なセキュリティ対策が求められています。

生成AIのセキュリティで押さえるべき基本概念

生成AIにおけるセキュリティ対策を考える際には、従来から存在するリスクと、生成AI特有の新たなリスクの両方を理解することが不可欠です。

この2種類のリスクを明確に整理することで、自社にとっての優先課題や対策方針が見えやすくなります。

「情報漏洩」「誤情報」「著作権侵害」など従来型リスク

生成AIの導入によって、既存のセキュリティリスクがさらに拡大する可能性があります。

例えば社員がうっかり社外秘情報をプロンプトとして入力してしまうと、その情報がAIモデルに学習され他のユーザーにも間接的に漏れる危険性があります。

また、AIが出力する文章や画像の中に既存著作物の一部が含まれていた場合、それが著作権侵害となるリスクもあります。

これは学習データの出所がブラックボックス化しているAIに共通する問題です。

さらに誤った情報(ハルシネーション)に基づいて意思決定がなされると、業務上のミスや顧客への誤案内といった実害につながるため、重大な問題に発展しかねません。

「プロンプトインジェクション」「データポイズニング」などAI特有のリスク

生成AIの利用ではこれまでにない新しい攻撃手法にも注意が必要です。

代表的なものとして以下のようなリスクが挙げられます。

■プロンプトインジェクション

攻撃者が特定の命令を埋め込んだプロンプトを使うことで、AIに意図しない動作をさせたり、非公開の情報を出力させる手法です。

■データポイズニング

AIの学習段階において、意図的に不正確または有害なデータを混入させることで、AIの挙動を操作しようとする攻撃です。

これらのリスクは生成AIが外部とのインターフェースを持つ性質上、従来よりも発生しやすくなっています。

特にAPI経由でAIを活用する企業にとっては技術的なセキュリティ対策が欠かせません。

生成AIにおけるセキュリティリスクの種類と事例

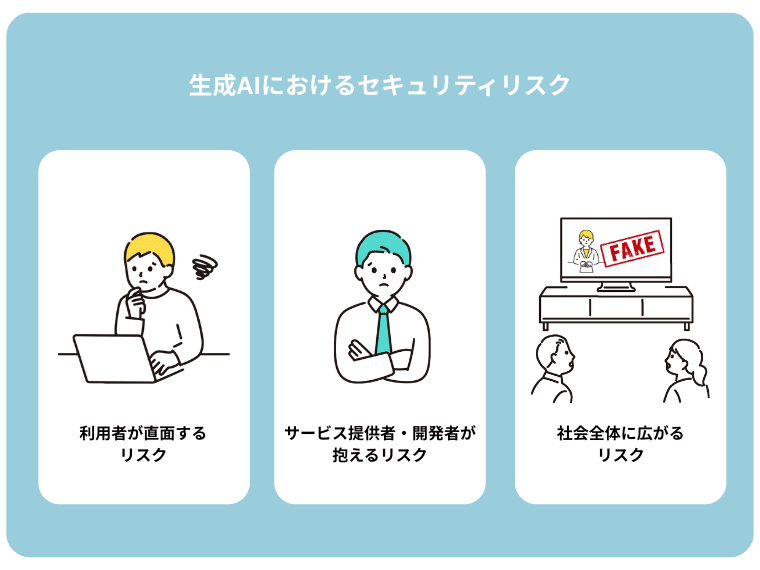

生成AIに関するセキュリティリスクは、単に技術的な問題だけにとどまらず、利用者・提供者・社会全体のあらゆる層に影響を及ぼす可能性があります。

本セクションではリスクの対象を以下の3つに分類し、それぞれの立場に応じた具体的なリスクと事例を解説します。

- 利用者が直面するリスク

- サービス提供者・開発者が抱えるリスク

- 社会全体に広がるリスク

このように分類することで自社がどのポジションにあるかを意識しながら、必要なセキュリティ対策を検討しやすくなります。

利用者が直面する生成AIのセキュリティリスク

生成AIを日常業務で利用する一般社員や担当者は、無意識のうちに重大なリスクを引き起こす可能性があります。

特に「入力内容の取り扱い」や「生成結果の誤認」は、業務に直接的な影響を与えます。

社員の誤入力による機密情報漏洩

実際に多くの企業で発生しているのが、生成AIに対して社外秘や顧客情報などの機密情報を誤って入力してしまうケースです。

例えば国内の大手IT企業では、社員がChatGPTに業務資料を貼り付けて要約を依頼した結果、情報が社外のAIサーバーに送信され社内ルール違反として問題視されました。

このような誤入力は一見便利に思える操作の中で自然に起こるため、「本人に悪意がない」点がさらに対策を難しくしています。

情報管理の意識やルールが整備されていない企業では、同様の事故がいつ起きてもおかしくありません。

誤情報(ハルシネーション)による意思決定ミス

生成AIはもっともらしい内容を出力する一方で、事実とは異なる誤情報を提示することがあります。

これを「ハルシネーション」と呼びます。

例えばある営業部門では、生成AIが出力した製品仕様の誤情報を元に顧客提案を行い、信用を損なう結果となった事例があります。

特に技術用語や法的表現を含む文書において誤りが含まれていた場合、ミスは即ビジネスリスクに直結します。

生成AIの出力内容を過信せず必ず人間がファクトチェックを行う体制づくりが必要です。

サービス提供者・開発者側の生成AIのセキュリティリスク

生成AIを提供・開発する側にもまた、独自のセキュリティリスクがあります。

特にAIモデルの設計や学習データの選定に起因するリスクは、ユーザーへの影響が広範囲に及ぶため、開発段階からの慎重な対応が求められます。

モデルの脆弱性やサイバー攻撃の標的化

生成AIモデルには設計上のバグや推論アルゴリズムの欠陥といった「脆弱性」が存在することがあります。

これらは、攻撃者によってプロンプトインジェクションや逆探索といった方法で悪用される恐れがあります。

実際に公開されたオープンソースAIモデルに対して、外部からのプロンプト操作により出力内容を制御された事例も報告されています。

AIモデルは一度構築したら終わりではなく、常に監視・改修を続けるサイクルが欠かせません。

著作権・法令違反リスク

生成AIの出力には学習データに基づいた内容が含まれるため、知らぬ間に著作権を侵害してしまうリスクがあります。

例えばあるイラスト生成AIが既存作品と類似した画像を出力し、著作権侵害で訴訟トラブルに発展したケースも存在します。

また、個人情報や機密情報が学習データに含まれていた場合、プライバシー保護や個人情報保護法への違反とみなされる可能性もあります。

こうしたリスクを回避するには、データガバナンスとリーガルチェック体制の構築が必須です。

社会全体に広がる生成AIのセキュリティリスク

生成AIの進化は企業や個人だけでなく、社会全体にも大きな影響を及ぼします。

悪用された場合のインパクトは非常に広範囲で、時には社会的混乱を引き起こす要因ともなりえます。

ディープフェイクの悪用

生成AIによる映像・音声の合成技術、いわゆる「ディープフェイク」は、政治家や有名人の偽動画を作成し、世論操作や詐欺に利用される事例が報告されています。

特に選挙や大規模イベントの時期には、これらが社会的混乱や信頼失墜を引き起こす恐れがあります。

AIで生成されたコンテンツが「本物のように見える」ことが問題の本質であり、一般ユーザーも簡単に騙されてしまうため、検証技術の進化と情報リテラシー教育の両面からの対策が急務です。

誤情報拡散による社会的混乱

生成AIが生み出した誤情報がSNSで拡散されることで、短時間で社会に混乱を招くケースも増えています。

例えばある国際情勢に関する誤報がAIによって生成され、複数のメディアが転載した結果、株式市場が一時的に大きく乱れた事例があります。

このような状況は今後さらに拡大していく可能性が高く、報道機関・政府・プラットフォーム事業者を含めた連携によるリスク抑制策が求められています。

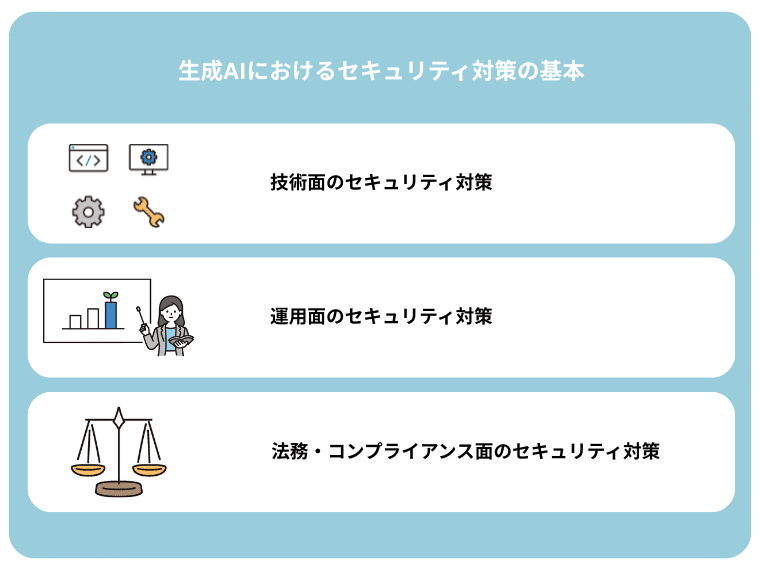

生成AIにおけるセキュリティ対策の基本

前章までで生成AIに関わるさまざまなリスクを確認しました。

本章ではそれらのリスクに対して実務でどのように対応すべきか、具体的なセキュリティ対策を3つの観点(技術・運用・法務)から整理します。

それぞれの対策を網羅的に把握することで、自社の現状と照らし合わせながら優先順位を明確にできます。

技術面のセキュリティ対策

生成AIの利用に際してまず確保すべきはシステムレベルでのセキュリティです。

とくに外部APIを利用する生成AIでは、入力データや出力結果がクラウド環境を経由するため、技術的な安全対策は不可欠です。

アクセス管理・権限設定

生成AIの操作に関して、誰が・どの範囲で利用できるかを明確に制限することで、情報漏洩や不正利用を未然に防ぐことができます。

- 利用者ごとのロールを設定し、社外秘情報を扱う部門のみ利用可能にする

- 外部AIサービスへのアクセスログを取得し、不審な操作がないか監視する

- 特定のプロンプト入力(例:顧客名、契約書文面など)を制限する仕組みを設ける

こうした「入口制御」が、重大な事故を防ぐ最初の壁となります。

データ入力制御・暗号化

生成AIの活用において入力される情報の中には、機密性の高いデータが含まれる可能性があります。

例えば、顧客名や契約内容、製品仕様などの情報がそのままプロンプトとして送信されれば漏洩リスクが生じます。

このような事態を防ぐためには、利用者が入力する内容に対して事前に制御をかける仕組みが必要です。

具体的には不適切なキーワードの入力を検出してアラートを出す仕組みや、入力内容をマスキングして送信する機能などが挙げられます。

またAIとの通信経路や保存データについては、すべて暗号化を行うことが望ましく、通信の安全性を高めると同時に、第三者による不正アクセスを未然に防ぐ効果が期待できます。

これらの対応は特にクラウド上のサービスを利用する場合には必須の施策となります。

ログ監視と検知システムの導入

生成AIの導入後はその運用状況を可視化し、異常を迅速に察知できる体制を整える必要があります。

特に誰が・いつ・どのような入力を行い、どのような出力を得たのかというログを取得・保存することは、万が一のトラブル発生時の検証や責任所在の明確化に直結します。

さらに、短時間に大量の出力が行われるような不自然な挙動や、過去と比較して著しく傾向の異なるプロンプトが繰り返されているようなケースは、攻撃や不正利用の兆候である可能性があるため、リアルタイムでのアラート通知や自動検知が求められます。

高度なセキュリティ監視を行うには、SIEM(Security Information and Event Management)などの専門的なソリューションを導入し、生成AIの運用環境全体を包括的に監視することが効果的です。

運用面のセキュリティ対策

システム面が整っていても実際にそれを使うのは「人」であるため、ヒューマンエラーを前提とした運用体制も構築しなければなりません。

ここからは運用面におけるセキュリティ対策を見ていきましょう。

社員教育と利用ルールの徹底

生成AIのセキュリティ対策はシステム面だけで完結するものではありません。

実際にAIを操作するのは社員であり、そのリテラシーの高さが事故の発生率を大きく左右します。

特に、プロンプトへの誤入力や不用意な情報共有といったヒューマンエラーは、技術的な防御だけでは完全に防ぎきれないため、社員一人ひとりが正しい理解を持つことが不可欠です。

そのためには、全社的な研修やeラーニングを通じてリスク認識を醸成するとともに、現場で遭遇しがちな具体的な失敗事例を取り上げたケーススタディ形式の教育が効果を発揮します。

単にルールを覚えさせるだけでなく「なぜそれが危険なのか」を、納得感をもって理解してもらうことで、日常業務の中でも自然と正しい判断ができるようになります。

ガイドラインや社内ポリシー策定

生成AIを導入する際にはその利用範囲や禁止事項、責任の所在などを明文化したガイドラインや社内ポリシーの整備が不可欠です。

例えば「業務で利用できるAIの種類」「入力してよい情報と禁止すべき情報の区別」「生成されたコンテンツの社内外での使用条件」などを具体的に示すことで、現場の混乱や判断ミスを防ぐことができます。

こうしたポリシーは一方的に定めるのではなく、情報システム部門、法務部門、実務部門が連携し、それぞれの立場からの視点を取り入れることが重要です。

また、テクノロジーの進化や外部環境の変化に応じて、定期的に見直しを行い、必要に応じてアップデートする柔軟性も求められます。

ポリシーは「作って終わり」ではなく「現場で活かされてこそ意味がある」ことを念頭に、運用のしやすさにも配慮することが大切です。

法務・コンプライアンス面のセキュリティ対策

生成AIの導入では知らぬ間に法的トラブルに巻き込まれる可能性があるため、法務・コンプライアンス観点のチェックも欠かせません。

個人情報保護法や著作権法の遵守

生成AIの活用において見落とされがちなのが、法令との整合性です。

とりわけ個人情報保護法や著作権法に抵触するリスクは高く、軽視すべきではありません。

例えば顧客の氏名や住所といった個人情報をAIに入力して処理を依頼した場合、それがAIの学習データとして保持されたり、第三者に予期せぬ形で共有されたりする可能性があります。

また、生成物の中に既存著作物と類似した表現が含まれることで、著作権侵害を問われる事例も報告されています。

こうしたトラブルを未然に防ぐには社内の運用ルールに法的な視点を組み込み、必要に応じて専門の法務担当者や外部の法律事務所による事前チェックを受ける体制を整えることが望ましいです。

技術だけでなく法的リスクを正しく理解し、それに対応できる企業姿勢が求められます。

国内外のガイドライン・規制対応

生成AIに関する規制は国際的に急速に整備が進められており、企業はそれらに遅れることなく対応していく必要があります。

日本国内では、内閣サイバーセキュリティセンター(NISC)やIPA(情報処理推進機構)などが、生成AIの安全利用に関するガイドラインを発表しており、これらの内容を社内ポリシーに反映させることが推奨されています。

また、海外においてはEUのAI規則(AI Act)やアメリカの商務省が示す政策ガイドラインなど、法的拘束力を持つ制度が次々と導入されており、グローバルに事業を展開する企業は、各国の動向を常にモニタリングする必要があります。

特に現地の法規制に違反した場合には、高額な罰金や信用失墜といった重大なリスクが伴うため、単なる形式対応にとどまらず実効性のある施策として組織全体で取り組む姿勢が求められます。

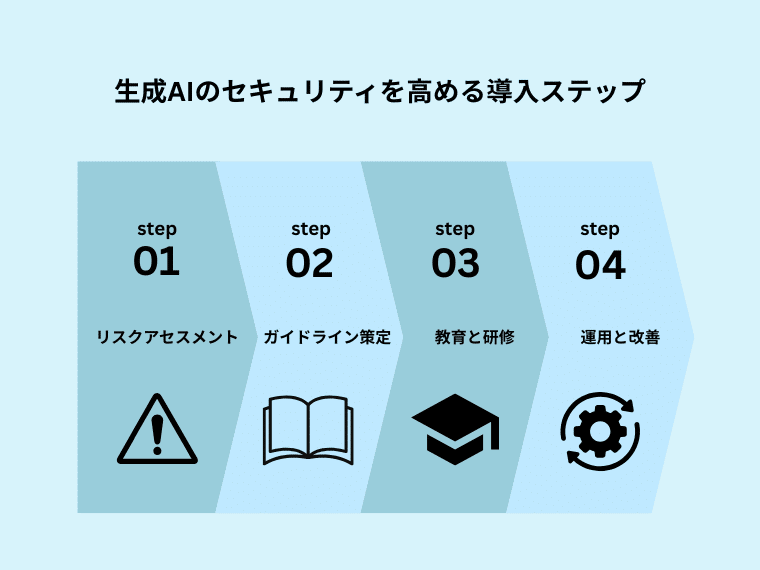

生成AIのセキュリティを高める導入ステップ

生成AIを業務に安全に取り入れるために、思いつきでツールを導入するのではなく、段階的なプロセスを経てリスクを管理しながら運用を開始する必要があります。

本章では「評価 → 方針策定 → 教育 → 改善」という4つのステップを通じて、実務レベルで取り組める導入プロセスを紹介します。

これらのステップは業種や組織規模にかかわらず応用可能であり、生成AIのリスクを最小化しながら効果的な活用を実現するための土台となります。

ステップ1:リスクアセスメント

生成AIの導入に先立ち、まず行うべきは自社にとっての潜在的なリスクを明らかにするリスクアセスメントです。

利用シーンによって、直面するリスクは異なります。

たとえば、社内の文章作成支援に使う場合と、顧客対応の自動化に使う場合とでは、求められるセキュリティレベルが大きく異なるためです。

この段階ではAIがどのような情報にアクセスするのか、誰が利用するのか、そして誤作動や情報漏洩が発生した場合にどのような影響があるかを洗い出します。

また、過去に同業他社で起きたインシデント事例なども参考にすることで、自社にとっての優先リスクがより明確になります。

リスクの種類と影響度を見極めた上で必要な対策の方向性を検討していくことが、導入ステップ全体の起点となります。

ステップ2:ガイドライン策定

リスクを把握したら次に必要なのはそれに基づいた社内ルールの整備です。

生成AIは利便性が高い反面、使い方次第では大きなリスクを伴います。そのため利用目的や禁止事項、運用体制などを明文化したガイドラインを策定し、組織全体で共通認識を持つことが不可欠です。

このガイドラインは単にドキュメントを作成するだけでなく、実務で使いやすい内容にすることが重要です。

例えば「生成物の社外利用は禁止」「個人情報や契約情報は入力不可」といった具体的かつ現場で判断しやすい表現を用いることが推奨されます。

また、情報システム部門や法務部門など関係部門との連携を図りながら、現実的かつ実効性のあるルールを定めることが組織全体のリスク低減につながります。

ステップ3:教育と研修

ルールが整備されてもそれを正しく理解して実行できるかどうかは、利用者である社員一人ひとりにかかっています。

そのため導入と並行して教育・研修のプログラムを実施し、生成AIの特徴やリスク、操作上の注意点について確実に理解してもらうことが求められます。

教育内容としては生成AIがどのように動作するのか、どのような誤情報(ハルシネーション)が生じるか、そしてどのような情報を入力してはいけないのかといった点が中心となります。

また、実際にツールを操作しながら学ぶハンズオン形式の研修を取り入れることで、理解の定着率を高めることができます。

特に非IT部門の社員にとっては、実務に即した事例とともに学ぶことで実際の業務でも自然とリスク回避ができるようになります。

ステップ4:運用と改善

生成AIの導入はゴールではなくスタートに過ぎません。

ルールと教育を整備した後も実際の運用状況を継続的に監視し、必要に応じて改善していく体制が不可欠です。

例えばログを分析して誤った入力が頻発していないかを確認したり、新たなリスクが浮上していないかを定期的にレビューしたりすることが求められます。

また、技術の進化や規制の変更に対応するため、社内のポリシーも定期的に更新していく必要があります。

その際には現場からのフィードバックを反映しながら、実際に運用しやすい形でルールを調整することが大切です。

改善を重ねながら安全性と利便性を両立させた生成AIの活用環境を構築していくことが、長期的なリスク管理と企業価値の向上に直結します。

生成AIセキュリティの最新事例から学ぶ

生成AIを安全に活用するには理論やルールだけでなく、実際に起きた成功・失敗の事例から学ぶことが非常に重要です。本章では国内外で報告されたセキュリティインシデントや、効果的な活用によって成果を上げた成功事例を取り上げ、それぞれの事例から得られる教訓や対応策を明らかにしていきます。

実際の現場で起きた問題を通じてリスクが現実のものであることを認識し、自社の対策に反映するきっかけとしていただけると幸いです。

画像生成AIによる著作権侵害訴訟:Midjourney vs. Disney & Universal

2024年ハリウッドの大手映画スタジオであるウォルト・ディズニー社およびユニバーサル・スタジオが、画像生成AIプラットフォーム「Midjourney」に対し、著作権侵害の疑いで提訴したことが大きな話題となりました。

この訴訟ではAIが生成した画像の中に『スター・ウォーズ』や『マーベル』のキャラクターに酷似した描写が含まれていたことが問題視されました。

特に著作権で保護されたキャラクターや美術スタイルがAIによって学習・模倣され、それが商業的に利用される可能性がある点に対して、スタジオ側が強い危機感を表明しています。

この件は、生成AIが第三者の著作物をどのように取り扱うべきかという法的論点を浮き彫りにするとともに、企業にとってもAI生成物を業務利用する際のリスクを再認識させるものとなりました。

とくに商用利用を検討している企業にとっては、生成物の内容を十分に精査し、著作権に関わる部分については慎重な対応が求められます。

出典:Disney and Universal Sue AI Company Midjourney for Copyright Infringement

書籍を学習に使用したAI企業とフェアユースを巡る論争:Anthropicの訴訟事例

Anthropicは自社のAIモデル「Claude」の学習に公開書籍を用いたことについて、2024年に複数の出版社から著作権侵害の疑いで訴訟を起こされました。

問題となったのは物理的に購入した書籍をスキャンし、AIに学習させた行為が「フェアユース(公正使用)」に該当するかどうかという点でした。

この訴訟において米連邦地裁はAnthropicの主張を一部認め、商用利用を伴わずかつ情報の変換や要約といった変化が加えられている場合には「フェアユース」が成立する可能性があると判断しました。

ただし無許可での書籍の全編利用については引き続き慎重な判断が必要であるとされ、訴訟は継続中です。

この事例は生成AIの開発元がどのようなデータを学習に使っているのかという点が、ユーザー側にとっても重大な関心事となり得ることを示しています。

特に企業がAIサービスを選定する際には、そのAIが「何を学習しているか」「その過程が法的に問題ないか」を確認することが今後より一層重要になっていくでしょう。

出典:Anthropic Settles High-Profile AI Copyright Lawsuit Brought by Book Authors

成功事例から見るベストプラクティス

一方で適切なルールと体制を整えることで、生成AIを安全かつ効果的に活用している企業もあります。

例えばある大手金融機関では社内向けのFAQ作成に生成AIを活用しています。

あらかじめ定義されたテンプレートに沿ってAIが原案を生成し、それを専門部署が精査・修正するというフローを確立したことで、業務の効率化と情報の質を両立させることに成功しました。

また医療分野の企業では医療関係者向けの教育コンテンツ制作にAIを活用していますが、導入前に専門家によるリスク評価とガイドライン策定を実施し、特定のキーワードや専門用語については生成AIに使用を制限する設定を行うといった対応を行う企業もあります。

このように人の判断を組み合わせた「ハイブリッド運用」によって、リスクを抑えつつAIの利点を引き出す方法が注目されています。

これらの成功事例に共通するのは、「AIを信用しすぎない」「人の判断を介在させる」「プロセスを明文化する」といった基本原則を地道に実行している点にあります。

ツールの性能ではなく使う側の仕組みづくりが、安全な生成AI活用の鍵を握っています。

まとめ|生成AI セキュリティで安心して業務活用するために

本記事では生成AIを業務に活用する際に直面するセキュリティリスクと、その対策について段階的に整理しました。

まず生成AI特有のリスクとして、プロンプトインジェクションやデータポイズニングといった新しい攻撃手法が存在すること、さらに従来型の情報漏洩や著作権侵害リスクが拡大する可能性を確認しました。

続いて利用者・提供者・社会全体の3つの立場からリスク事例を紹介し、社員の誤入力やモデルの脆弱性、ディープフェイクなど、立場ごとに異なる脅威を明らかにしました。

こうしたリスクに対応するためには技術的な防御策の導入、運用上の教育やガイドライン策定、法的観点でのコンプライアンス徹底という三層の対策が不可欠です。

そのうえで、リスクアセスメントからガイドライン策定、社員教育、継続的な改善へと進む導入ステップを踏むことで、安全性と利便性を両立させたAI活用環境を実現できます。

また、MidjourneyやAnthropicを巡る国際的な訴訟事例からも分かるように、著作権やフェアユースといった法的枠組みは企業にとって直接的なリスク要因であり、国内外の規制動向を注視することが欠かせません。

生成AIは企業の競争力を高める強力なツールですが、セキュリティを軽視すれば情報漏洩や信用失墜といった深刻な代償を招く可能性があります。

リスクを正しく理解し、実効性のある対策を講じることで、初めて安心して業務に組み込むことができます。

自社に合った仕組みを整え生成AIを安全に活用することが、これからの企業成長にとって不可欠な条件となるでしょう。

「生成AIとkintoneを使って業務効率化を図りたいけど、技術が足りない」「生成AIを使いたいけど、セキュリティが心配」と悩んでいませんか?

Smart at AIはkintone内で簡単・安全・効率的にChatGPTなどの生成AIが使えるようになるkintone連携サービスです。

Smart at AIを使って課題解決やセキュリティ強化・業務改善を検討されている企業様は、ぜひお気軽にご相談ください。

お問い合わせはこちらkintoneをもっと便利にするプラグイン・連携サービスを提供中

全サービスが乗っているカタログを今すぐ無料ダウンロード!

![Smart at M-SOLUTIONS[stg]](https://smartat.jp/wp-content/uploads/2023/02/logo.png)